当ブログにはPRを含みます。

2024年3月中旬に正式なAWS認定に追加されたData Engineer – Associateという資格試験があります。筆者も取得したため試験概要や勉強方法について紹介します。

はじめに:筆者の受験時の状況と受験結果

筆者は、データエンジニアリングについては全くの未経験でした。一方、AWSを用いたシステム開発プロジェクトでアーキテクチャ設計やプロジェクトマネジメントの経験はありました。また、ソリューションアーキテクトプロフェッショナル(SAP)などの複数のAWS認定は保有していました。

- IT企業でAWSプロジェクトマネジメントやアーキテクチャ設計経験あり(3年ほど)

- SAP、DOP、SAA、DVA、SOA取得済み

- データエンジニアリング未経験

筆者は約1ヶ月(2時間×30日)学習し、826点で1発合格することができました。勉強時間についてはこれまでの経験の程度や他AWS認定の有無によって大きく変わると思います。

Data Engineer Associate(DEA)の概要

Data Engineer Associate(DEA)はアソシエイトレベルのAWS認定資格です。

もともとから存在する認定資格Data Analytics – Specialty(DAS)がベースになっています。SpecialtyからAssociateに変更されているので、難易度は易しくなっています。

| 資格名 | AWS Certified Data Engineer – Associate |

| 試験時間 | 120分 |

| 出題形式 | 選択問題 |

| 言語 | 日本語、英語、韓国語、中国語 |

| 問題数 | 65問 |

| 合格ライン | 720点/1000点 |

| 試験日 | 随時 |

| 試験場所 |

全国のピアソンテストセンター または 試験監督付きオンライン受験 |

| 受験料 | 20,000 円 |

| 合格発表 | 5営業日以内にメールで通知 (筆者は受験後1時間ほどでメールが来ました) |

| 有効期限 | 3年 再認定試験は、認定資格が有効期限切れになる 60 日前から受験可能 |

| 受験要件 | なし |

Data Engineer Associate(DEA)出題範囲、サービス

Data Engineer Associate(DEA)はAssociate(中級)に当たる試験です。試験範囲はデータ分析や機械学習です。

試験範囲は以下となっています。※詳細な試験範囲は公式試験ガイドをご覧ください。

- 第 1 分野: データの取り込みと変換 (採点対象コンテンツの 34%)

- 第 2 分野: データストア管理 (採点対象コンテンツの 26%)

- 第 3 分野: データ運用とサポート (採点対象コンテンツの 22%)

- 第 4 分野: データセキュリティとガバナンス (採点対象コンテンツの 18%)

- データ処理と分析:Amazon EMR, AWS Glue, Amazon Redshift, Athena, Kinesisなど

- データストレージ:Amazon S3, Amazon RDS, DynamoDB, Redshiftなど

- セキュリティとガバナンス:IAM, KMS, CloudTrail, Macieなど

※試験では、AI/ML、プログラミング言語の詳細な構文、ビジネスの結論を導くタスクは範囲外とされています。

難易度(例題付き)

SAAの勉強方法は以下の記事で紹介しています。よろしければぜひご覧ください。

レベル感的にはソリューションアーキテクトアソシエイト(SAA)に近いと感じました。出題範囲はData Analytics – Specialty(DAS)と重複するところがあります。AWS公式は以下の難易度としていますが、筆者的にはSAAレベルの知識があれば2~3ヶ月も勉強すれば取得できると思います。

- データエンジニアリング経験:2〜3年のデータエンジニアリング実務経験を持ち、データの取り込み、変換、モデリング、セキュリティ、ガバナンス、プライバシーに関する深い知識を持っていること。

- AWSサービスの経験:1〜2年以上のAWSサービスの実務経験が推奨されます。

以下、Data Engineer Associate(DEA)のサンプル問題です。正解を確認する場合▼を押下してください。

あるデータエンジニアは、AWS Glue の抽出、変換、ロード (ETL) パイプラインをデプロイするための新しいアカウントを作成しました。パイプラインジョブは、ソース Amazon S3 バケットから raw データを取り込む必要があります。その後、パイプラインジョブは、変換されたデータを同じアカウントの宛先 S3 バケットに書き込みます。データエンジニアは、AWS Glue がソース S3 バケットと宛先 S3 バケットにアクセスするためのアクセス許可を含む IAM ポリシーを作成しました。データエンジニアは、ETL パイプラインを実行するために IAM ポリシー内のアクセス許可を AWS Glue に付与する必要があります。

これらの要件を満たすソリューションはどれですか。

A. IAMユーザを作成し、キーペアを作成する。このユーザにポリシーを適用し、Glueジョブにアクセスキーとシークレットアクセスキーを設定する

B. 適切な権限を付与したIAMポリシーを作成し、Glueジョブにアタッチする

C. 適切な権限を持つIAMポリシーを作成し、IAMロールにアタッチする。このIAMロールを使用するようにGlueジョブを設定する。

D. S3バケットそれぞれにリソースポリシーを作成する。

正解:C

IAMの知識があれば解ける問題でした。

A:この方法でも可能だが、アクセスキーとシークレットアクセスキーの管理が必要でセキュアではない。

B:ポリシーを直接ジョブにアタッチすることはできない。

C:正解。リソースに権限を与えるときの第一選択肢としてIAMロールが推奨される。

D:S3側ではなく、Glue側に権限を付与する必要がある。

Data Engineer Associate(DEA)勉強方法と教材

Data Engineer Associate(DEA)は新しい資格試験であるため、教材の数が限られています。教材とともに学習方法を紹介します。

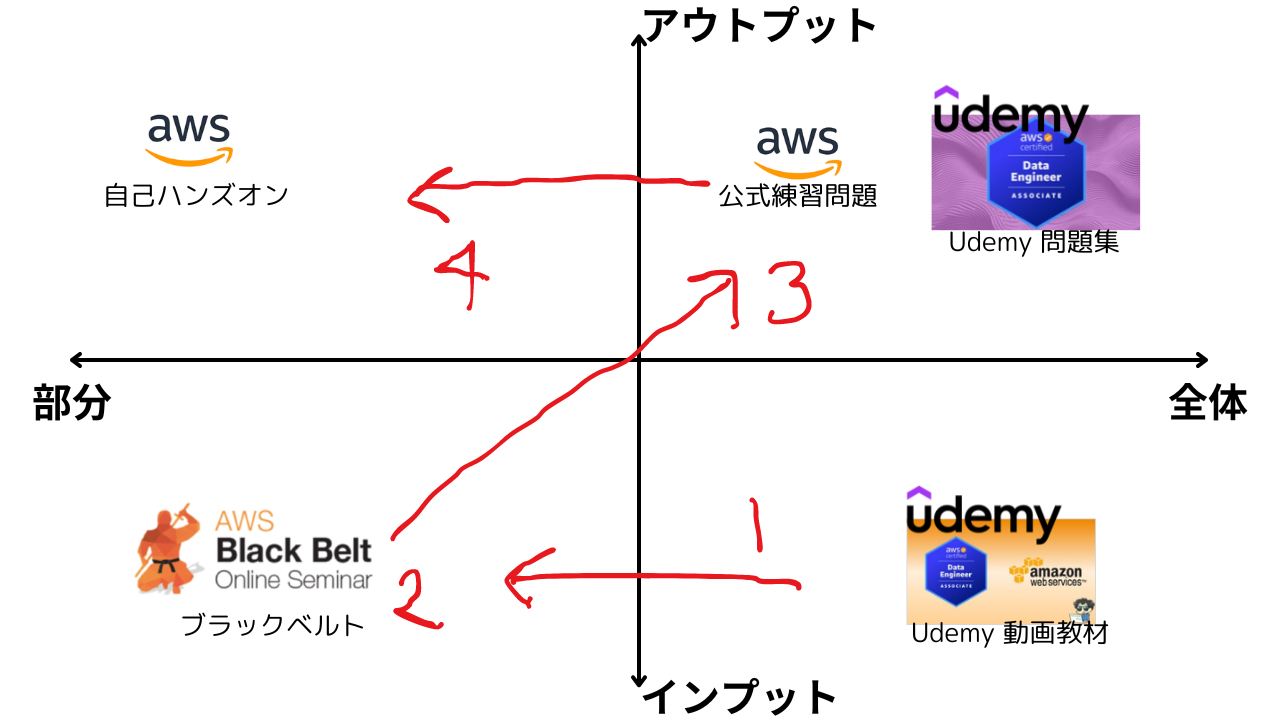

あらゆる資格学習において共通ですが、全体を学習し、その後に部分学習すると効果的です。また学習初期はインプット学習し、次第にアウトプット学習を意識しましょう。学習に詰まったらChatGPTを活用することもおすすめです。後の章で具体的な使い方も紹介します。

-

STEP1: 初心者は動画で基礎を学ぶ (1週間程度)

初心者はまず動画教材で網羅的に学習することをおすすめします。DEAは参考書未発売のため、試験範囲の網羅学習は動画教材の視聴をおすすめします。 -

STEP2: 部分的なサービスの深堀にはブラックベルトシリーズを活用 (1週間程度)

AWSの各サービスを詳しく学ぶためには、AWSブラックベルトシリーズがおすすめです。DEAに頻出なサービスは視聴しておくことをおすすめします。 -

STEP3: 問題演習は必須 (2週間程度)

問題集を解き、出題傾向や弱点を把握して試験対策を進めます。 -

STEP4: 不明点を中心にハンズオン (2週間以上 任意)

実際に手を動かすことで、知識を実践に応用するスキルを身に着けます。資格取得の効率性を重視する方はスキップ可能ですが、実務能力を身に着けたい方はぜひ取り組んでください。

学習にはUdemy教材がおすすめです。教材のアップデートが早いのでDEAのように新しい資格にも対応できます。また、サブスク制ではなく、買い切りなので時間をかけて学習する方にもおすすめです。

- 30日以内であれば返金可能(気軽に始められる)

- 教材購入後もコンテンツがアップデートされる(頻繁にアップデートされるクラウド学習に最適)

- 不明点を講師に質問可能

- スマホでも視聴可能(隙間時間の活用)

- 月に数回(2~3回)実施するセールでは数万円のコースも2,000円程度に割引される(安価!)

STEP1: 初心者は動画で基礎を学ぶ (1週間程度)

全体のインプット学習にはUdemyの動画教材を使った学習が最適です。もし、学習を始める時点で以下のAWSサービスについてある程度の知識がある方はSTEP1やSTEP2はスキップしていきなり問題演習に取り掛かってもよいと思います。

Udemy動画教材の使い方について、画面を交えて詳しく説明しています。ぜひ以下の記事をご覧ください。

記事の内容:

- Udemy動画教材の便利な機能紹介: 再生速度調整、トランスクリプト表示、字幕対応などの機能

- スマホ機能の紹介: コースのダウンロード機能やバックグラウンド再生

- QA方法紹介: 講師への質問方法

- データの収集とインジェスト: Amazon Kinesis, AWS Glue, Amazon Managed Streaming for Apache Kafka (MSK), AWS Data Pipeline, Amazon SQS

- データの保存と管理: Amazon S3, Amazon RDS, Amazon Redshift, Amazon DynamoDB, AWS Lake Formation

- データの処理と変換: AWS Glue, AWS Lambda, Amazon EMR, AWS Step Functions

- データの分析と可視化: Amazon QuickSight, Amazon Athena, Amazon Elasticsearch Service (OpenSearch), AWS Data Exchange

- セキュリティ: AWS IAM, AWS KMS, Amazon CloudWatch

上記サービスについて不安な要素がある場合、動画教材視聴して試験範囲を網羅的に学習することをおすすめします。学んだ要点をノートアプリに記録しながら復習することで、知識が定着するのでおすすめです。ノートアプリはPCで書込み、スマホで見直すという使い方がおすすめです。

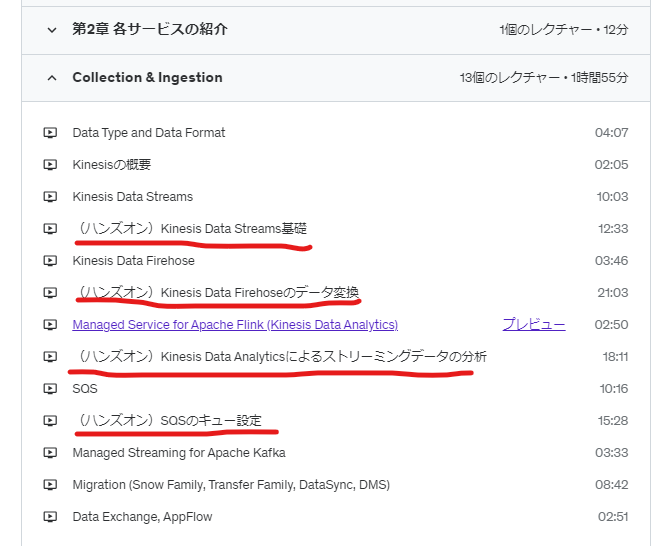

本動画教材にはハンズオンが付属していますが、試験合格の効率性を求める方はスキップしてもよいと思います。筆者もハンズオンはSTEP3の問題演習の後に実施しました。また、本教材に付属している模擬問題はSTEP2のブラックベルト視聴も完了して時点で解きました。

↓講座のリンクです。リンク先で20分程度のプレビューを無料視聴可能なのでぜひ確認してみてください。(定価:5,600円 セール時参考価格1,600円程度)

AWS認定Data Engineer Associate(DEA-C01)試験 対策トレーニング

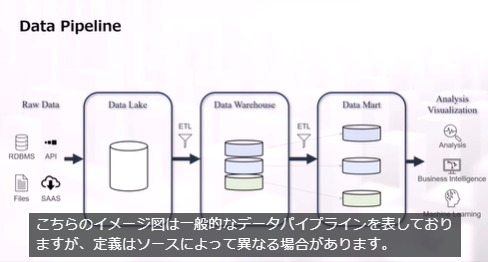

一般的なデータパイプライン、AWSでの実現方法やAWSの各サービスについて視覚的にわかりやすく解説してくれます。

-

価格:

- 定価5,600円

- セール時参考価格1,600円前後(変動あり)

- 動画時間: 10時間

- レビュースコア: (4.1/5)

-

特徴:

- 試験範囲の網羅解説

- ハンズオン付き

- 予想問題と解説付き

- 問題集有無: 問題演習あり(50問)

-

良いレビュー:

- 試験範囲を網羅しており実用的。解説、問題集、ハンズオンが含まれておりお得。

-

悪いレビュー:

- やや難しく感じる。

STEP2: 部分的なサービスの深堀にはブラックベルトシリーズを活用 (1週間程度)

AWSブラックベルトシリーズは、AWSの各種サービスや技術に関する日本語の解説資料やウェビナーがあります。各サービスの詳細な技術情報や活用方法がまとめられており、Data Engineer Associate(DEA)取得を目指す際の知識補完や部分学習に非常に役立ちます。特に、試験範囲に含まれる主要サービスの理解を深めるための教材として最適です。理解が不十分なサービスがあれば、ブラックベルトを視聴して理解を補強しましょう。おすすめの使い方は以下の通りです。

- DEA試験で頻出の主要サービスの理解を強化する

- 動画教材で理解しきれなかったサービスを深く学習する

- 問題演習で理解が不足していたサービスについて、知識を補完する

以下のサービスの中で、理解が不十分なものがあれば、ぜひブラックベルトで視聴しておきましょう。DEA試験に頻出するサービスです。

- データ処理と分析:Amazon EMR, AWS Glue, Amazon Redshift, Athena, Kinesisなど

- データストレージ:Amazon S3, Amazon RDS, DynamoDB, Redshiftなど

- セキュリティとガバナンス:IAM, KMS, CloudTrail, Macieなど

BlackBeltは以下のサイトで公開されています。

STEP3: 問題演習は必須 (2週間程度)

試験対策として、模擬問題を繰り返し解くことが大切です。出題形式に慣れるためにも、繰り返し演習を行い、安定して80%以上の正答率を達成できるようになれば本番試験の受験を考えてもよいと思います。

最初は問題に慣れていないと思うので不正解が続いても問題ありません。間違える過程で解説を読んで知識を蓄積させていきましょう。間違えた際、解説を熟読するのは勿論のこと、再度STEP1とSTEP2のインプット学習に立ち返ることが大切だと思います。

注意すべき点は、答えを丸暗記しないことです。本質を理解しないまま問題を繰り返すのは逆効果です。同じ問題を解きなおす際は少なくとも3日以上開けると効果的だと思います。間違えた都度、間違えた問題を記録しておきましょう。

もし同じ問題で何度も間違える場合、それはその問題に関連する何らかの知識が不足していると考えられます。この場合は、しっかりとインプット学習に立ち返り、関連する周辺知識も含めて習得することが重要です。

以下のように10問区切りで問題を解いていくと、解いた記憶が新鮮なうちに解説を読むことができるのでおすすめです。

- 10問解く

-

答え合わせを行う

- 間違えた箇所は解説を読む

- 正解した問題も、他の選択肢がなぜ不正解かを考えながら解説を読む

- 理解不足をブラックベルトや動画教材に立ち返って知識を広げる(STEP1~2に立ち返る)

この10問区切りの学習を繰り返すと必ず正答率が上がってきます。そうしたら65問のフルセットを解いてみましょう。80%以上の正答率が出たら、本番受験の申し込みをしましょう。

このようにして、段階的に学習を進めることで、効率よくDEA試験に備えることができます。AWS公式練習問題とUdemyのおすすめWEB問題集を紹介します。

問題集1: AWS公式練習問題

無料の練習用模擬試験を利用できます。全20問で何度も受験することができます。

問題数は少ないですが公式が出しているだけあって、難易度や出題形式は本番試験ほぼそのままです。まずは解いてみて出題形式と難易度の把握に利用するのが良いと思います。

この模擬試験を受験するにはAWSスキルビルダーへの登録が必要です。上記リンク先からも無料で登録できるのでおすすめです。

問題集2: Udemy 英語問題集(世界ベストセラー)

本WEB問題集は筆者がベータ試験対策する際に使用しました。問題のクォリティが高く、解説も丁寧です。

Udemy問題集の使い方について、実際の画面を交えて詳しく説明しています。ぜひ以下の記事をご覧ください。

記事の内容:

- 【神アップデート!】解答を都度確認する方法を解説。(1問1答)

- Udemyの問題集をPCやスマートフォンで効果的に活用する方法を解説。

- ブラウザ翻訳機能を使い英語問題集を日本語に翻訳する手順を紹介。

- 問題演習画面の操作方法や解答確認の仕方を詳しく説明。

- 講師への質問方法を説明。

ブラウザの自動翻訳機能を使用することによって日本語で解くことができます。本問題集はサンプル問題が付属しているので以下に紹介します。

問題集のサンプル問題を確認する(Chrome自動翻訳)

クラウド データ エンジニアリング コンサルタントは、クライアントのために Amazon S3 と Amazon Redshift の間のデータ転送プロセスを最適化する任務を負っています。クライアントのデータ ウェアハウジング ソリューションでは、複雑なクエリを実行するために大規模なデータセットを Redshift に定期的にロードする必要があるほか、長期保存およびさらなる処理のためにクエリ結果を S3 に定期的にアンロードする必要があります。コンサルタントは、これらのロードおよびアンロード操作が効率的かつ安全に実行されるようにする必要があります。

これらの操作を効果的に実行するには、コンサルタントはどの方法の組み合わせを推奨する必要がありますか? (2つ選択してください)

A) Amazon Redshift の COPY コマンドを使用して、Redshift の MPP (Massively Parallel Processing) アーキテクチャを利用して Amazon S3 からのデータロードを並列化します。

B) INSERT INTO コマンドを使用して S3 から Amazon Redshift にデータをロードし、データの整合性のためにトランザクションがログに記録されるようにします。

C) Redshift Spectrum を実装して、Redshift にロードせずに Amazon S3 上のデータを直接クエリし、データの移動を削減します。

D) データセキュリティのために暗号化を有効にして、UNLOAD コマンドを使用してクエリ結果を S3 に自動的にアンロードするように Redshift を設定します。

E) S3 と Redshift の間でデータを移動するためのカスタム スクリプトを使用して AWS Data Pipeline をセットアップし、転送中に複雑なデータ変換を可能にします。

ここで 推測してみましょう。正解は… [下にスクロール]

.

.

.

正解:

Amazon Redshift の COPY コマンドを使用して、Redshift の MPP (Massively Parallel Processing) アーキテクチャを利用して Amazon S3 からのデータロードを並列化します。

- COPY コマンドは、Amazon S3 から Amazon Redshift に大量のデータをロードするために特別に設計されています。Redshift の MPP アーキテクチャを利用して高速並列ロードを実行します。これは、大規模なデータセットを効率的に処理するのに最適です。

データセキュリティのために暗号化を有効にし、UNLOAD コマンドを使用してクエリ結果を S3 に自動的にアンロードするように Redshift を構成します。

- Amazon Redshift の UNLOAD コマンドは、データを S3 にエクスポートするように設計されています。COPY コマンドと同様に並列アンロードを実行でき、転送プロセス中にデータのセキュリティを維持するための暗号化をサポートします。

不正解:

INSERT INTO コマンドを使用して S3 から Amazon Redshift にデータをロードし、データの整合性のためにトランザクションがログに記録されるようにします。

- INSERT INTO コマンドは、Amazon Redshift にデータを追加するために使用できますが、一括操作には適していません。個々のトランザクションを処理する方法のため、大規模なデータセットの場合は COPY コマンドよりも効率が低くなります。

Redshift Spectrum を実装すると、Amazon S3 上のデータを Redshift にロードせずに直接クエリできるため、データの移動が削減されます。

- Redshift Spectrum では、Redshift にデータをロードせずに S3 内のデータをクエリできますが、このシナリオでは特に、さらなる処理のためにデータの移動が必要となるため、Spectrum はロード/アンロード操作の主要な方法ではなく補助ツールになります。

S3 と Redshift の間でデータを移動するためのカスタム スクリプトを使用して AWS Data Pipeline をセットアップし、転送中に複雑なデータ変換を可能にします。

- AWS Data Pipeline はデータ移動を調整するためのサービスですが、S3 と Redshift の間でデータを移動する特定のユースケースでは、Data Pipeline でカスタム スクリプトを作成するよりもネイティブの COPY および UNLOAD コマンドを使用する方が効率的で複雑さが軽減されます。

参照:

- Amazon S3 からのデータのロード

- Amazon S3 へのデータのアンロード

注: 参考セクションには実際の模擬試験へのリンクがあります。

215問で定価2,600円です。セール時には1,600円程度になることがあります。

Practice Exams | AWS Certified Data Engineer Associate-

価格:

- 定価: ¥2,600

- セール時参考価格: ¥1,600

- レビュースコア: (4.5/5)

- 特徴: 質の高い問題と詳しい解説

- 問題数: 215問

-

レビュー:

- 解説が詳しい。本番さながらの難易度。問題が豊富。

問題集3: Udemy 日本語問題集

本問題集は筆者がDEAを受験した後に発売されました。一部のレビューで「解答が間違っているのではないか?」という記載が散見されます。気になる方はUdemyの返金サービスを当てにして試してみるのはいかがでしょうか。

190問で定価2,600円です。セール時には1,600円程度になることがあります。

【DEA-C01対応 2024年版】AWS認定 データエンジニア アソシエイト 模擬問題集【2回+α 計190問】-

価格:

- 定価: ¥2,600

- セール時参考価格: ¥1,600

- レビュースコア: (4.1/5)

- 特徴: 本番ライクな問題と詳しい解説

- 問題数: 190問

-

良いレビュー:

- 解説が詳しい。

-

悪いレビュー:

- 解答が誤っていると思われる箇所がある。

STEP4: 不明点を中心にハンズオン (2週間以上 任意)

ハンズオンで実際にデータパイプラインを構築してみると実務に役立つ知識を身に着けることができます。

取り合えず試験合格の効率性を重視する方はハンズオンをスキップしても構いません。ハンズオンは実践的な知識を身に着けるには最適ですが、時間がかかります。

また、ハンズオンはある程度AWSの基礎力を身に着けてから実施することをおすすめします。単に動画で説明されていることをなぞるだけで意味を理解していないと効果が薄れてしまうからです。少なくともSAA合格レベルの知識を身に着けてからハンズオンを実施することをおすすめします。

ハンズオンのやり方としては、STEP3までの学習で理解しきれていないサービスを個人AWSアカウントで触ってみることがおすすめです。筆者の場合、Glueの利点が理解しきれていなかったため、実際に触ってみました。その際のことを以下の記事にしました。よろしければぜひご覧ください。

また、ハンズオンを体系的に実施したい方はSTEP1の動画教材のハンズオンパートがおすすめです。

各章に複数のハンズオンがあります。

学習補助ツール: ChatGPTの活用方法を紹介

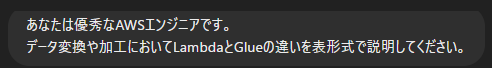

学習を進めていて疑問が生じたときは、ChatGPTに質問することで疑問を解消できます。ChatGPT単に「〜とは何ですか?」と聞くだけでも答えてくれますが、以下のポイントを意識することで、より有益な回答が得られます。

- 誰になってほしいのかを示す。

- 例:「あなたは優秀なAWSエンジニアです。」

- 求める情報の粒度やレベルを示す。

- 例:「300文字以内で説明してください。」「初心者にもわかるように説明してください。」など

- 何かを比較したい場合は表も作成できる。

- 例:「LambdaとGlueの違いを表で説明してください。」

- 解答が間違っている可能性があることを理解する

- 生成AIは間違った情報を返すこともあります。AWS公式HP等で裏どりするとベストです。

- 最新のChatGPT 4oでは、かなり正確な情報が得られるようになったと感じていますが、常に裏付けを取る姿勢が大切です。

以下の例ではAWSのデータ変換に使えるサービスであるLambdaとGlueの違いについて聞いてみました。

LambdaとGlueの違いについてかなり参考になる応答が返されました。チャットの中で気になる点がある場合、続けて質問することもできます。以下の例では「(GlueとLambdaでは)利用料金は一般的にどちらが安くなるか?」を聞いてみました。

追加質問の回答の内容も非常に正確でわかりやすい内容が返却されていました。まるでAWSに詳しいエンジニアが知恵袋などで回答してくれているように感じます。

まとめ

AWS Data Engineer Associate(DEA-C01)は、データエンジニアリングに関する基本的な知識とスキルを問う新しいアソシエイトレベルの試験です。特にデータの取り込み、変換、ストレージ管理、セキュリティの分野での実践的なスキルが求められます。学習においては、動画教材や問題集を活用し、ステップごとに段階的に学ぶことが効果的だと思います。

- STEP1: 初心者はまず動画教材で基礎を学習し、試験範囲全体の概要を把握しましょう。

- STEP2: 部分的な深堀にはAWSブラックベルトシリーズを利用し、特定サービスの理解を強化します。

- STEP3: 問題演習で実力をチェックし、出題形式に慣れ、間違えた箇所はインプットに戻り知識を補完することが大切です。

- STEP4: 必要に応じてハンズオンで実務能力を高めることもおすすめですが、試験合格の効率を重視するならば、問題演習に集中するのもありです。

また、学習の過程で疑問が生じた場合にはChatGPTなどのツールを活用し効率的に学習可能です。しっかりと準備を進めれば、DEA資格の取得は難しくありません。自身の学習ペースに合わせて、最適な教材と手法で合格を目指しましょう!

以上です。最後までお読みいただきありがとうございました!

システムエンジニア

AWSを中心としたクラウド案件に携わっています。

IoTシステムのバックエンド開発、Datadogを用いた監視開発など経験があります。

IT資格マニアでいろいろ取得しています。

AWS認定:SAP, DOP, SAA, DVA, SOA, CLF

Azure認定:AZ-104, AZ-300

ITIL Foundation

Oracle Master Bronze (DBA)

Oracle Master Silver (SQL)

Oracle Java Silver SE

■略歴

理系の大学院を卒業

IT企業に就職

AWSのシステム導入のプロジェクトを担当